Aunque la pandemia ha tenido un impacto negativo en muchas áreas, incluido el mercado laboral y muchos sectores industriales, también ha habido una tendencia a que los científicos de datos tengan más proyectos de salud que nunca. Los expertos húngaros de Starschema, pioneros en el análisis de datos, nos contaron algunos detalles interesantes sobre su trabajo, donde los datos se pueden poner al servicio de la salud.

El big data (una cantidad asombrosa de datos o información que llega rápidamente y no puede ser analizada por los medios tradicionales) es una de las expresiones más avanzadas de los últimos años que todos saben que tiene un gran potencial, pero pocos saben cómo aprovecharlo en el ejercicio. Fundada en 2006, la húngara Starschema, que se ocupa de inteligencia empresarial y big data, es una auténtica artillera en este campo: la empresa ya ha trabajado con clientes como Netflix, Disney, Facebook o Tesla.

El objetivo de la ciencia de datos es desarrollar y usar algoritmos que puedan usarse para explorar relaciones complejas usando estadísticas, aprendizaje automático y grandes cantidades de técnicas de procesamiento de datos. La mayoría de estas correlaciones conducen a nuevos conocimientos comerciales: podemos saber qué campañas de marketing vale la pena comunicar a cada cliente, qué tipo de tarjeta de crédito sospechamos que es fraudulenta o en qué enfermedades pueden estar involucrados ciertos genomas. Hemos cubierto algunas aplicaciones en el pasado donde los datos pueden ser una ventaja en las decisiones comerciales:

Una de las lecciones de la pandemia y de este año es que las industrias farmacéutica y de atención médica están comenzando a hacer un mejor uso que nunca del potencial de los datos, y Starschema explica su expansión principalmente a través de solicitudes de grandes empresas, incluidas consultas de gigantes farmacéuticos. Esto se debe a que las compañías farmacéuticas se han visto muy afectadas por la incertidumbre del mercado sobre el COVID-19. Para la planificación comercial (mejora de las capacidades de producción, planificación de la actividad de ventas, desarrollos, etc.), no fue posible partir de los datos de ventas del año anterior y las tendencias en 2020, por lo que se implementaron nuevos modelos de pronóstico, respaldados por la tecnología de la compañía y los servicios de inteligencia comercial. necesario. El año pasado, los gigantes farmacéuticos extranjeros utilizaron estos servicios a un ritmo mayor que antes, la empresa se asoció con 24.hu.

tamas voldi Según el CEO, con la aceleración global de la digitalización, existe una creciente demanda por parte de sus clientes para desarrollar nuevos productos digitales y servicios de análisis de datos. «El mercado es muy burbujeante. El sector analítico global, actualmente estimado en $30 mil millones, está creciendo alrededor de un 25 por ciento anual, y es probable que el impulso continúe hasta el final de la década», dijo Fuldi.

Los alérgenos también pueden estar satisfechos con los datos.

La mayoría de estos proyectos operan en completo secreto, ya que el tipo de datos que se procesan facilita inferir lo que está haciendo la competencia, por lo que no se pueden nombrar todos los clientes o proyectos. El algoritmo Starschema también está fallando en la aplicación de uno de los predictores de alergias gigantes sin nombre en los Estados Unidos. La aplicación puede predecir con un 80 por ciento de precisión cómo se sentirá el usuario en los próximos días. La predicción se basa en un algoritmo de aprendizaje automático y el modelo de datos que se creó con él.

El servicio se basa principalmente en tres fuentes de datos:

- datos de polen vinculados a una ubicación geográfica específica,

- datos del tiempo,

- y comentarios de los usuarios.

En base a esto, el algoritmo calcula lo que puede esperar una persona alérgica, y cuantos más datos proporcione sobre cómo se siente, más precisa será la predicción con el tiempo. Actualmente, la aplicación solo está disponible en América del Norte, pero planea expandirse a Europa. Un gran golpe para futuros desarrollos es proporcionar al usuario información no solo sobre su bienestar esperado, sino también sobre el polen al que pueden ser sensibles en función de sus síntomas.

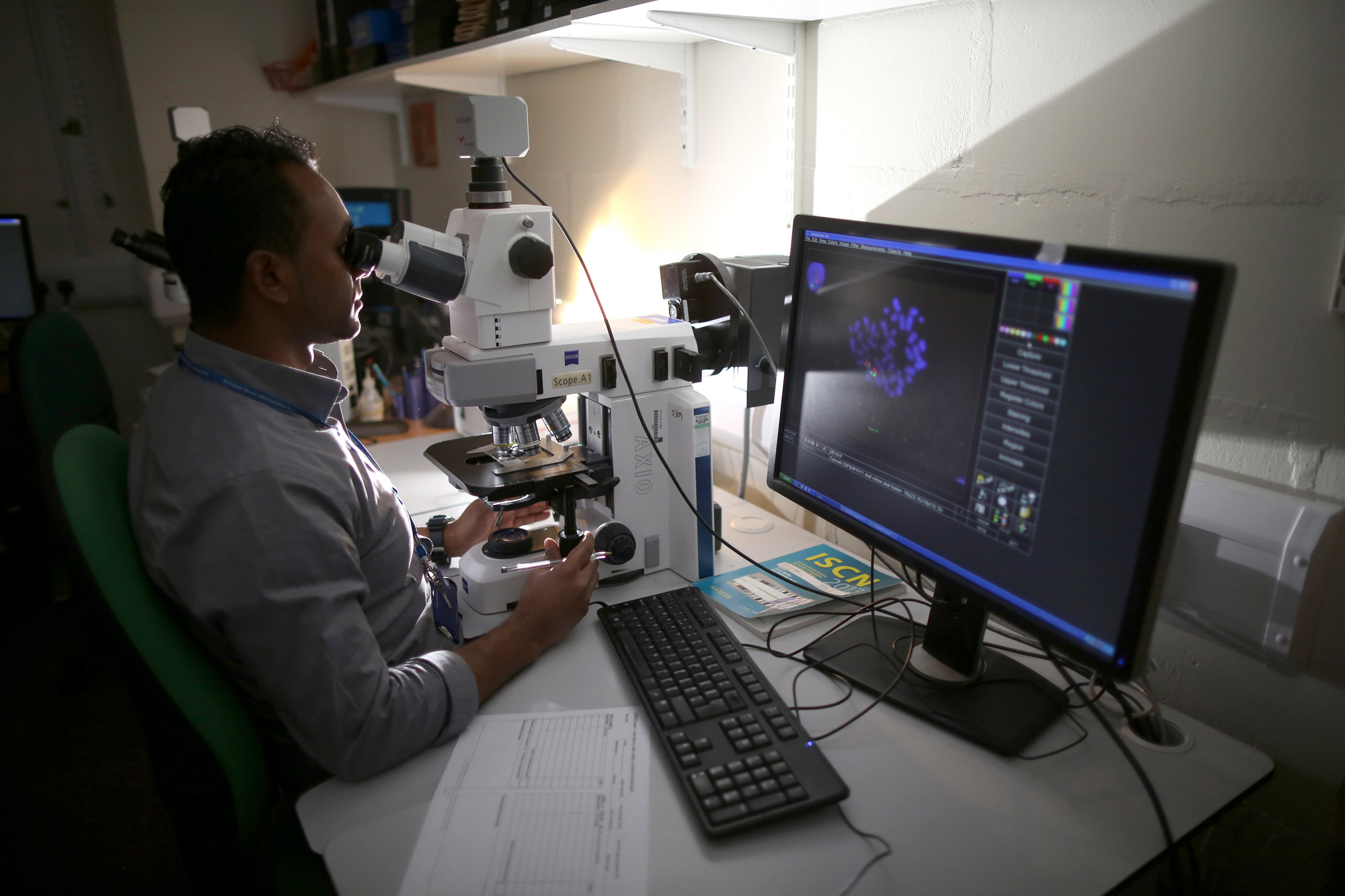

La empresa también ha trabajado con Richter Gedeon Plc en un proyecto de investigación sobre neurofármacos. Un área problemática en la investigación neurofarmacéutica es analizar la forma de la llamada red mitocondrial en micrografías 3D. Las mitocondrias son básicamente las centrales eléctricas de las células, estos pequeños órganos que convierten los nutrientes en la energía necesaria para que nuestras células funcionen. El software que describe la arquitectura de red y el aprendizaje automático se puede utilizar para distinguir automáticamente entre tejido sano y dañado. La metodología es un paso importante en los procesos de descubrimiento de fármacos para los que aún no existe una solución automatizada. Anteriormente, los biólogos analizaban las estructuras celulares y eso era mucho más lento, por lo que se podía hacer lo mismo automáticamente.

Nos dijo que el análisis de datos también es una nueva forma de controlar automáticamente la calidad de las resonancias magnéticas. Windhager-Hell Esther, científico jefe de datos en Starschema. Por lo general, los médicos no pueden ver la grabación hasta semanas después, y si la calidad de la grabación no es buena, por ejemplo, porque el paciente se ha mudado, el sujeto deberá volver a programar una cita, lo que llevará mucho tiempo. La herramienta de análisis automatizada determina de inmediato si el examen es adecuado para el diagnóstico y, de no ser así, se puede realizar otro examen de inmediato.

Gracias a una asociación entre Starschema y el gigante tecnológico con sede en California Snowflake, líder en tecnologías de computación en la nube, el 25 de marzo se puso a disposición un sistema de información integrado que actualmente proporciona uno de los servicios de datos más completos del mundo y depende de recursos confiables relacionados con la pandemia. La recopilación de datos libre y gratuita puede ser de gran ayuda para los gobiernos, las principales empresas y organizaciones internacionales a la hora de tomar sus acciones y decisiones económicas extraordinarias.

Su complejidad se debe a que los desarrolladores la han complementado con información relevante como la ubicación geográfica de las enfermedades, los resultados detallados de las pruebas de laboratorio, la infraestructura de salud de la región, la demografía (edad media, proporción de sexos, densidad de población) o establecido medidas epidemiológicas. Los usuarios pueden acceder a los datos en un formato limpio y listo para el análisis que pueden integrar fácil y rápidamente con sus bases de datos.

La mayor parte de los datos y el poder asociados con la propagación del virus estaban en manos de los gobiernos, pero las empresas de telecomunicaciones con datos de ubicación completamente precisos de sus clientes también pueden aparecer en el gobierno como proveedores de datos. Como consultores, también participamos en un proyecto en el que la empresa de telecomunicaciones tenía que proporcionar datos al gobierno y ayudar a interpretar los datos. Por ejemplo, la cantidad de personas que se desplazan entre diferentes asentamientos o regiones es información útil para estimar la propagación del virus. Estos datos serán facilitados, por supuesto, de forma anónima.

Comparte otro ejemplo vikte choss, ajuste ciego.

Si bien estas son áreas muy interesantes en lo que respecta al uso de datos, en general, el 90 por ciento del análisis consiste en anuncios y contenido más específicos en todas las plataformas. Esto puede haber sido exacerbado por la pandemia, donde todos han estado pasando el rato en la red y haciendo lo que quieren, creando más datos. Windhager-Hell destaca las tendencias futuras en Análisis mejorado, es decir, el campo del análisis extendido.

«Incluso una empresa simple puede generar informes a partir de una variedad de métricas, de miles de tablas. De ahí surgió la necesidad de que los científicos de datos elijan aquellos de los informes que les interesan. Descubra dónde puede ver si el resultado no está en en línea con las tendencias pasadas, conduce a un desempeño peor o mejor Si lo tiene, también será necesaria la exploración causal: debe averiguar por qué esa región en particular está funcionando peor o mejor. Es muy difícil automatizar un proceso de este tipo, pero el la demanda es enorme por lo que se ha avanzado en metodologías e investigación”.

Los científicos de datos todavía tienen una gran demanda

Windhager-Hell dice que un científico de datos moderadamente capacitado puede obtener más consultas en Linkedln todos los días, y se necesita mucho para los profesionales con ese tipo de conocimiento. Aunque los cursos de ciencia de datos en el hogar también están disponibles, no hay un curso universitario definitivo a partir de ahora. El mayor problema, dijo el experto, es que las universidades no pueden mantenerse al día con la rapidez con que se desarrolla esta tecnología. En el momento en que se pueda enseñar el programa de estudios, será esencialmente obsoleto.

Siempre que no haya una formación especial para científicos o ingenieros de datos, un título en ciencias puede ser una buena base, incluso con conocimientos de matemáticas, física, programación y economía. Hay muchos cursos relacionados con el análisis de datos en la red, incluso gratuitos, que se pueden utilizar para reunir un nivel de conocimiento bastante alto.

También hay una gran demanda de científicos de datos, pero aún más de ingenieros y arquitectos de datos. Son responsables de recopilar datos y prepararlos en forma analítica. Hay menos profesionales de este tipo, ya que el 80 por ciento del flujo de trabajo es solo recopilación y preparación de datos, y el otro 20 por ciento se trata de crear modelos de análisis y pronóstico.

explica Windhager-Hell. La ingeniería de datos continúa donde termina la ciencia de datos: aquí, los modelos existentes deben ampliarse y escalarse. Este es un tipo puramente tecnológico, en el que la tarea no es crear algoritmos analíticos, sino hacer que el análisis de datos y la visualización de datos sean rápidos, incluso en tiempo real, incluso para grandes cantidades de datos. Este conocimiento está en demanda en todo el mundo, como en cualquier campo, tiene un fuerte enfoque para llegar a cualquier parte aquí.

«Quiero ser un aficionado a la televisión. Entusiasta certificado de la cultura pop. Académico de Twitter. Estudiante aficionado».